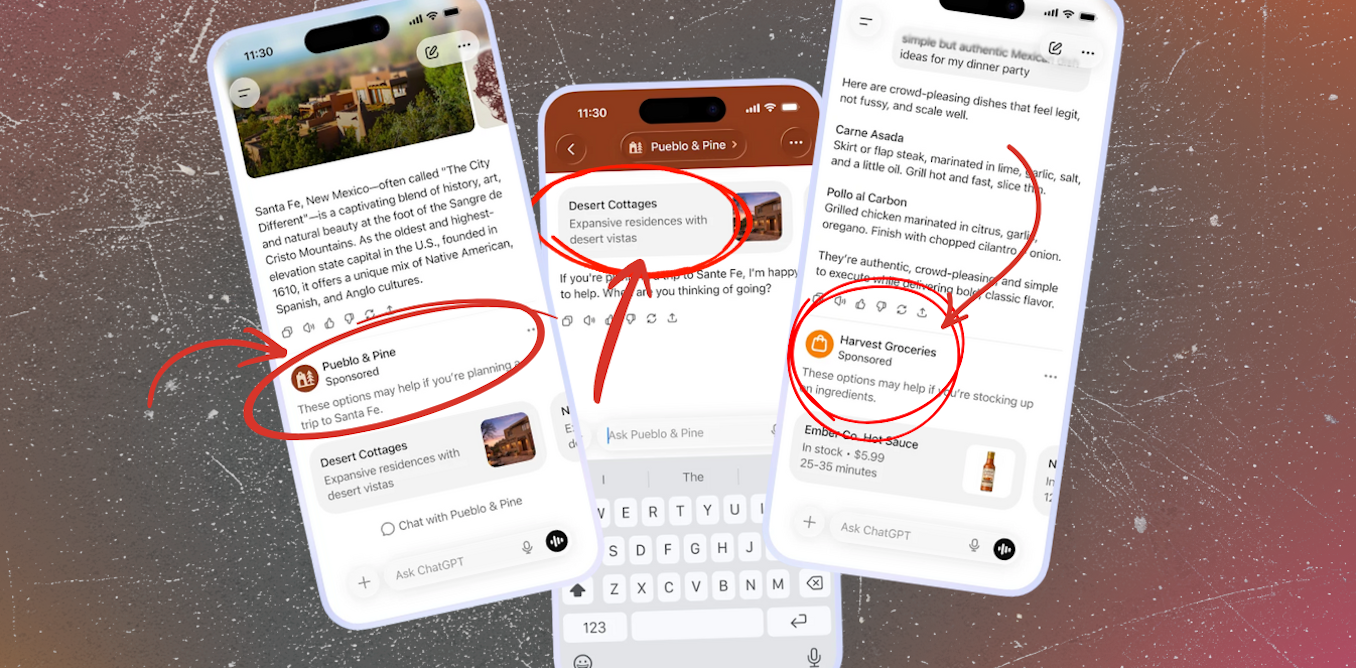

OpenAI anunciou planeja introduzir publicidade no ChatGPT nos Estados Unidos. Os anúncios aparecerão na versão gratuita e no nível Go de baixo custo, mas não para assinantes Pro, Business ou Enterprise.

A empresa afirma que os anúncios serão claramente separados das respostas do chatbot e não influenciarão os resultados. Também se comprometeu a não vender conversas de usuários, permitir que os usuários desativem anúncios personalizados e evitar anúncios para usuários menores de 18 anos ou sobre temas delicados, como saúde e política.

Ainda assim, o movimento levantou preocupações entre alguns usuários. A questão principal é se as salvaguardas voluntárias da OpenAI se manterão quando a publicidade se tornar central para o seu negócio.

Por que os anúncios em IA sempre foram prováveis

Já vimos isso antes. Há quinze anos, as plataformas de redes sociais lutavam para transformar grandes audiências em lucro.

A inovação veio com a publicidade direcionada: adaptar os anúncios de acordo com o que os usuários procuram, clicam e prestam atenção. Este modelo tornou-se a principal fonte de receitas para Google e Facebookremodelando seus serviços para maximizar o envolvimento do usuário.

Leia mais:

Por que a Internet está repleta de anúncios inúteis – e o que podemos fazer a respeito?

A inteligência artificial (IA) em grande escala é extremamente caro. O treinamento e a execução de modelos avançados exigem vastos data centers, chips especializados e engenharia constante. Apesar do rápido crescimento do número de utilizadores, muitas empresas de IA ainda operam com prejuízo. Somente OpenAI espera queimar US$ 115 bilhões nos próximos cinco anos.

Apenas algumas empresas conseguem absorver esses custos. Para a maioria dos fornecedores de IA, um modelo de receitas escalável é urgente e a publicidade direcionada é a resposta óbvia. Continua a ser a forma mais confiável de lucrar com grandes audiências.

O que a história nos ensina sobre as promessas da OpenAI

OpenAI diz isso manterá os anúncios separados das respostas e protegerá a privacidade do usuário. Estas garantias podem parecer reconfortantes, mas, por enquanto, baseiam-se em compromissos vagos e facilmente reinterpretados.

A empresa propõe não exibir anúncios “perto de temas delicados ou regulamentados como saúde, saúde mental ou política”, ainda oferece pouca clareza sobre o que é considerado “sensível”, até que ponto a “saúde” será definida de forma ampla ou quem decide onde ficam os limites.

A maioria das conversas do mundo real com IA ficará fora dessas categorias restritas. Até o momento, a OpenAI não forneceu detalhes sobre quais categorias de publicidade serão incluídas ou excluídas. No entanto, se nenhuma restrição fosse imposta ao conteúdo dos anúncios, é fácil imaginar que um usuário perguntando “como relaxar depois de um dia estressante” poderia ver anúncios de entrega de bebidas alcoólicas. Uma consulta sobre “ideias divertidas para um fim de semana” pode trazer à tona promoções de jogos de azar.

Esses produtos são ligados a danos reconhecidos à saúde e sociais. Colocados ao lado de orientações personalizadas no momento da tomada de decisões, esses anúncios podem orientar o comportamento de formas subtis mas poderosas, mesmo quando não é discutido nenhum problema de saúde explícito.

Promessas semelhantes sobre grades de proteção marcou os primeiros anos das mídias sociais. A história mostra como a autorregulação enfraquece sob pressão comercial, beneficiando em última análise as empresas e deixando os utilizadores expostos a danos.

Os incentivos publicitários têm um longo historial de minar o interesse público. O Escândalo Cambridge Analytica expôs como os dados pessoais coletados para anúncios poderiam ser reaproveitados para influência política. O “Arquivos do Facebook”revelou que a Meta sabia que suas plataformas estavam causando sérios danos, inclusive à saúde mental dos adolescentes, mas resistiu a mudanças que ameaçavam as receitas publicitárias.

Investigações mais recentes show Meta continua a gerar receita com fraudes e anúncios fraudulentos, mesmo depois de ser avisado sobre seus danos.

Por que os chatbots aumentam as apostas

Os chatbots não são apenas mais um feed de mídia social. As pessoas os usam de maneira íntima e pessoal para aconselhamento, apoio emocional e reflexão privada. Essas interações parecem discretas e sem julgamentos, e muitas vezes levam a revelações que as pessoas não fariam publicamente.

Essa confiança amplifica a persuasão de uma forma que as mídias sociais não conseguem. As pessoas procuram ajuda e tomam decisões quando consultam chatbots. Mesmo com a separação formal das respostas, os anúncios aparecem em um ambiente privado e de conversação, em vez de em um feed público.

As mensagens colocadas ao lado de orientações personalizadas – sobre produtos, escolhas de estilo de vida, finanças ou política – têm provavelmente mais influência do que os mesmos anúncios vistos durante a navegação.

Como a OpenAI posiciona o ChatGPT como um “superassistente”para tudo, desde finanças até saúdea linha entre conselho e persuasão fica confusa.

Para golpistas e autocratas, o apelo de uma ferramenta de propaganda mais poderosa é claro. Para os fornecedores de IA, será difícil resistir aos incentivos financeiros para acomodá-los.

A raiz do problema é um conflito de interesses estrutural. Os modelos de publicidade recompensam as plataformas por maximizarem o envolvimento, mas o conteúdo que melhor atrai a atenção é muitas vezes enganoso, carregado de emoção ou prejudicial à saúde.

É por isso que a restrição voluntária por parte das plataformas online falhou repetidamente.

Existe um caminho melhor a seguir?

Uma opção é tratar a IA como infraestrutura pública digital: estes são sistemas essenciais concebidos para servir o público em vez de maximizar as receitas publicitárias.

Isto não precisa excluir as empresas privadas. Requer pelo menos um produto de alta qualidade opção públicasupervisionados democraticamente – semelhante às emissoras públicas, juntamente com a mídia comercial.

Elementos deste modelo já existem. A Suíça desenvolveu o sistema de IA com financiamento público abertura através de suas universidades e centro nacional de supercomputação. É de código aberto, está em conformidade com a legislação europeia sobre IA e não contém publicidade.

A Austrália poderia ir mais longe. Paralelamente à construção das nossas próprias ferramentas de IA, os reguladores poderiam impor regras claras aos fornecedores comerciais: impor transparência, proibir publicidade política ou prejudicial à saúde e impor sanções – incluindo encerramentos – para violações graves.

A publicidade não corrompeu as redes sociais da noite para o dia. Isto mudou lentamente os incentivos até que o dano público se tornou o dano colateral do lucro privado. Trazê-lo para a IA conversacional corre o risco de repetir o erro, desta vez em sistemas em que as pessoas confiam muito mais profundamente.

A questão principal não é técnica, mas sim política: a IA deve servir o público, ou os anunciantes e os investidores?